(Dal punto di vista dell'esperienza degli sviluppatori e del valore a lungo termine della componibilità $VANRY )

Se mi chiedi: su cosa si basa l'infrastruttura AI-first per vincere? Non inizierò parlando di TPS, né di narrazioni. Inizierò facendo una domanda più "ingegneristica": gli sviluppatori possono integrare le capacità degli agenti come se stessero costruendo con i mattoncini, e farli funzionare stabilmente per un anno?

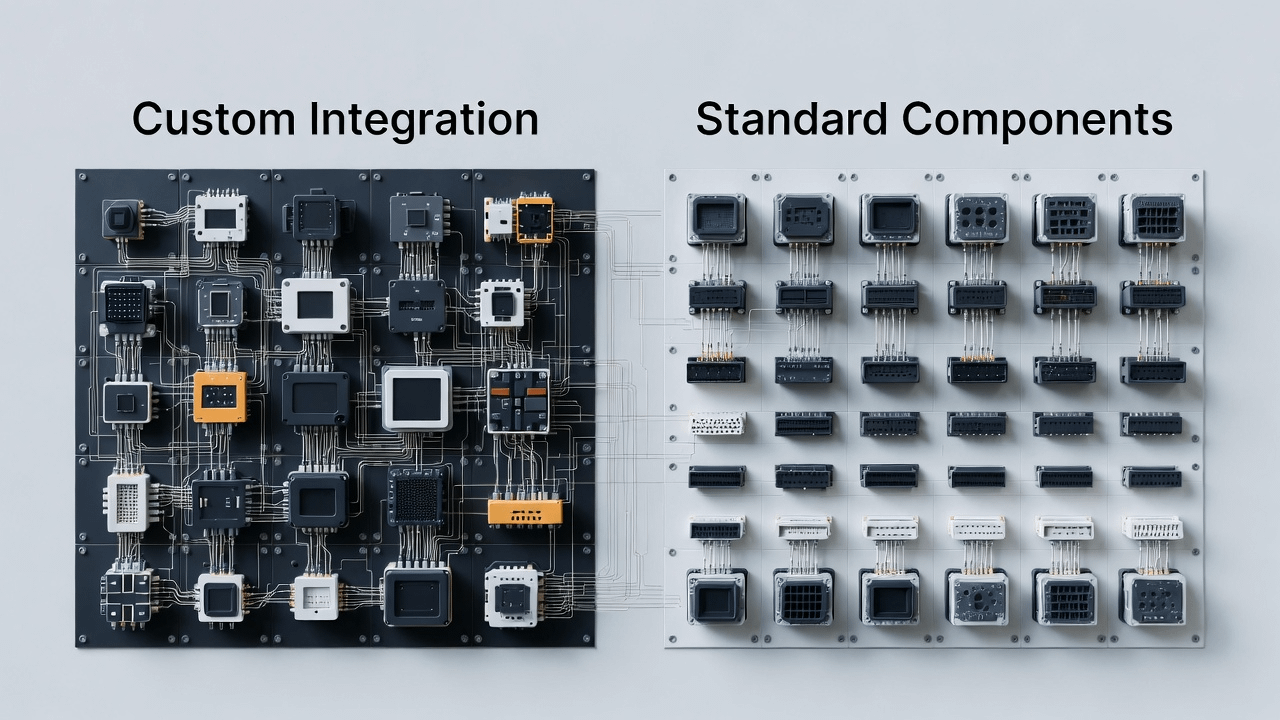

L'AI sta portando il Web3 in una nuova fase: non ci sono solo asset e contratti sulla catena, ma appariranno anche molti "moduli intelligenti". Sembrano molto simili a librerie e servizi nell'ingegneria del software: alcuni si occupano di memoria semantica, alcuni di ragionamento e spiegazione, alcuni di esecuzione automatizzata, alcuni di liquidazione e conformità. Il problema è: se queste capacità mancano di un modo di accesso unificato e di astrazioni di base riutilizzabili, gli sviluppatori si troveranno in un infinito "inferno dell'integrazione":

Ogni volta che si integra un componente intelligente, è necessario riadattare la struttura dei dati

Ogni volta che si cambia ecosistema, è necessario riscrivere un'intera strato di integrazione

Una volta che è realmente online, è difficile individuare il problema: è la memoria che è andata persa? Il ragionamento è sbagliato? Le condizioni di esecuzione non hanno avuto effetto? O il canale di liquidazione è bloccato?

Alla fine, gli agenti intelligenti si riducono a una serie di demo disperse, incapaci di scalare.

Questo è il modo in cui comprendo l'ingresso di Vanar: non si tratta di fare "AI più intelligente", né di fare "catene più veloci". Si tratta più di fare qualcosa di a lungo termine ma cruciale: ridurre le capacità fondamentali necessarie per gli agenti in componenti standard a livello di infrastruttura, consentendo agli sviluppatori di costruire applicazioni intelligenti pronte per il mercato con meno attriti.

In altre parole: la competizione nell'era dell'AI è spesso "chi è più facile da usare". Chi può abbattere i costi di accesso, ridurre i costi di riutilizzo e abbattere i costi trans-ecosistema, è più probabile che diventi la scelta predefinita.

1) AI-first vs AI-added: la differenza non sta nel modo di promuovere, ma nel "l'interfaccia è progettata fin dall'inizio per i moduli intelligenti"

Molte catene affermano "anche noi supportiamo l'AI". Ma guardando il flusso di lavoro reale degli sviluppatori, puoi notare la differenza:

"AI-added" è solitamente considerato come trattare l'AI come funzionalità a livello di applicazione, creando alcuni SDK, facendo alcune dimostrazioni e sperando che l'ecosistema cresca spontaneamente. Ma per scalare i moduli intelligenti, ciò che teme di più è: la base non ha riservato le interfacce e le astrazioni corrette per loro.

Il significato di AI-first è più specifico in ingegneria:

Sin dal primo giorno, si ipotizza che ci saranno molti agenti intelligenti che richiamano e collaborano con moduli intelligenti, quindi è necessario supportare più nativamente: la disponibilità a lungo termine dello stato, la tracciabilità del processo di ragionamento, l'automazione controllabile delle azioni e il ciclo chiuso della liquidazione. Questi non sono "aggiungere un pulsante funzionale"; è più come decidere fin dall'inizio come progettare il kernel del sistema operativo.

@Vanarchain dei Talking Points sottolinea "allineare l'uso reale, non la narrazione"; preferisco tradurlo in un linguaggio ingegneristico:

Non chiedere se puoi fare una demo, chiedi prima se puoi fornire agli sviluppatori una base di agenti intelligenti riutilizzabile e manutenibile.

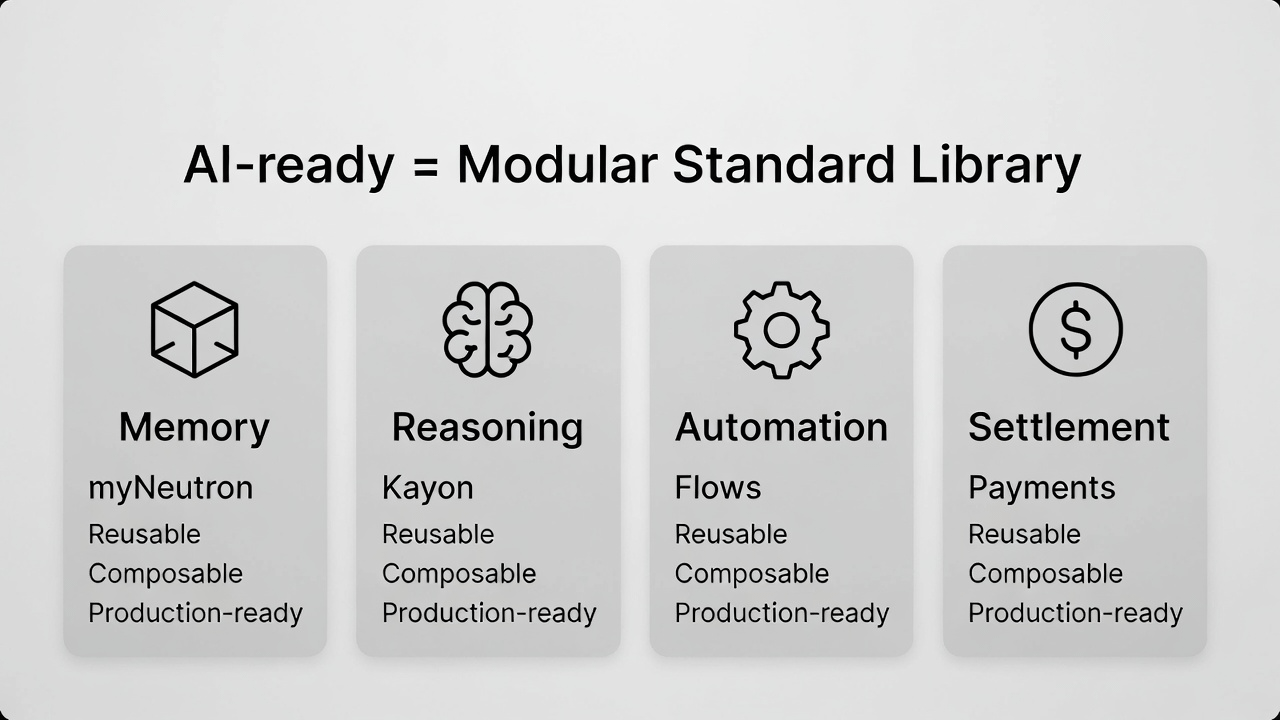

2) Cos'è veramente "AI-ready"? Dalla prospettiva degli sviluppatori, è quattro capacità di base "necessarie e in grado di collaborare".

Molte persone fraintendono "AI-ready" come "più veloce". Ma quando inizi a realizzare applicazioni per agenti intelligenti, scoprirai che la velocità è solo la superficie. La vera profondità è che le quattro capacità devono essere in grado di cooperare; altrimenti, l'intero sistema avrà difficoltà a uscire dal POC.

Memoria: non è "cosa si è discusso", ma è il contesto e lo stato semantico necessari per i compiti a lungo termine degli agenti.

Ragionamento: non è "dare risposte", ma è in grado di rendere comprensibile, riesaminabile e fidabile la catena decisionale.

Automazione: non è "in grado di eseguire", ma è in grado di trasformare l'esecuzione in componenti di processo stabili.

Liquidazione: non è "posso trasferire fondi", ma è in grado di trasformare le azioni degli agenti in un ciclo chiuso di attività economiche reali

Realizzare queste quattro cose non è difficile; ciò che è difficile è renderle componibili: gli sviluppatori possono metterle insieme come una libreria standard, evitando trappole, riscrivendo meno e riducendo i costi di integrazione.

@Vanarchain esempi di prodotto (myNeutron / Kayon / Flows) non li considererei come "tre funzionalità", ma piuttosto come tre componenti fondamentali:

Qualcuno è responsabile di trasformare "stato semantico" in capacità di base (corrispondente a myNeutron)

Qualcuno è responsabile di trasformare "ragionamento e spiegazione" in capacità riutilizzabili (corrispondente a Kayon)

Qualcuno è responsabile di trasformare "intelligente → azione" in capacità di flusso (corrispondente a Flows)

In aggiunta, il "tracciato di liquidazione/pagamento" rende l'applicazione chiusa, questa è la spiegazione completa di "AI-ready" in ingegneria.

3) Perché il rilascio di nuove L1 è più difficile nell'era dell'AI? Perché gli sviluppatori non mancano di catene, ma mancano di "middleware di agenti intelligenti maturi"

In passato, le nuove catene riuscivano ad attrarre sviluppatori dicendo "più veloci e più economiche". Nell'era dell'AI, questa logica sta diventando sempre più debole:

Gli sviluppatori hanno già molte catene a disposizione; ciò che manca sono middleware e componenti standard che possano rendere le applicazioni intelligenti più veloci da consegnare, più stabili e più facili da mantenere.

Se sei un team pronto a sviluppare applicazioni relative agli agenti AI, ciò che temi di più non è "non avere spazio per il dispiegamento sulla catena", ma:

Devi costruire il tuo sistema di memoria, rendere il ragionamento interpretabile, scrivere le tue barriere di esecuzione, integrare i canali di liquidazione.

Una volta avviato il business, i costi di mantenimento aumentano esponenzialmente.

Più hai successo, più il sistema è suscettibile di crollare a causa di un modulo non maturo.

Quindi, dire che "è difficile creare nuove L1" non significa che il mercato non abbia bisogno di nuove catene, ma significa: l'infrastruttura di una semplice nuova catena non è più rara; ciò che è raro è una combinazione di componenti intelligenti direttamente utilizzabile nella produzione. Questo è anche ciò che manca nei Talking Points di Vanar: "mancano i prodotti che dimostrano la prontezza dell'AI" - lo traduco come: ciò che manca è qualcosa che possa far risparmiare agli sviluppatori sei mesi di tempo di integrazione.

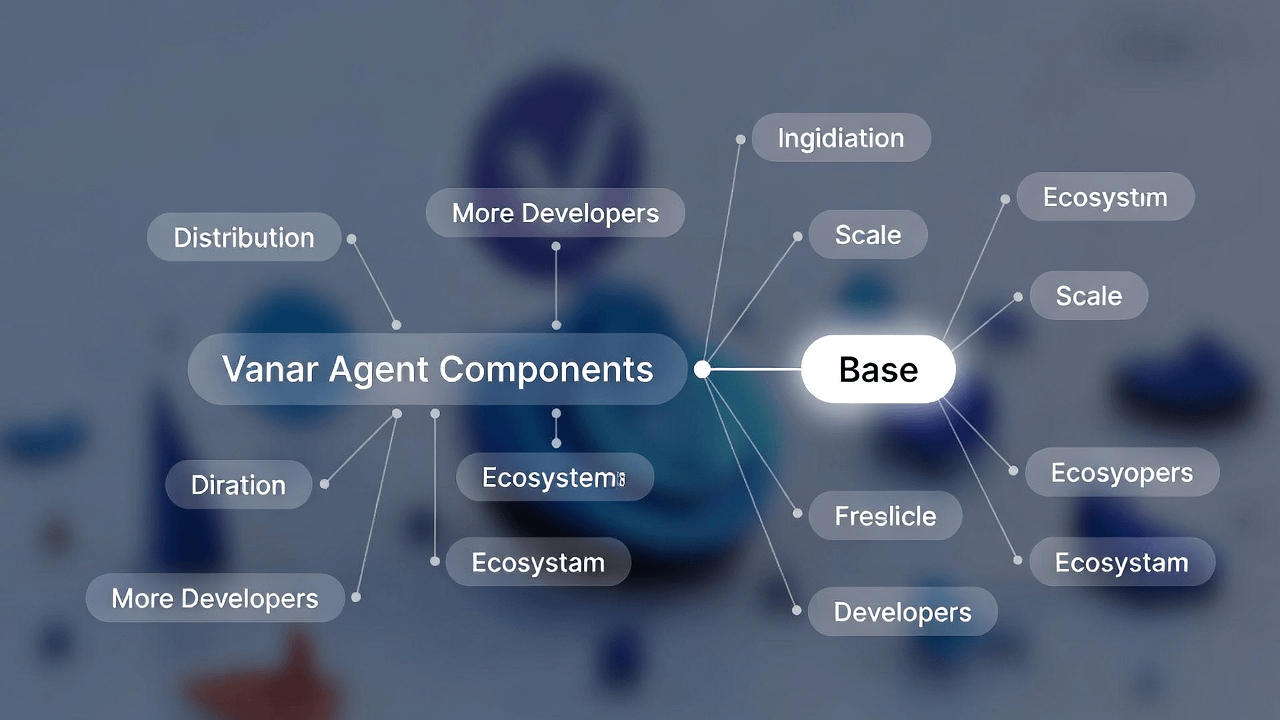

4) Inizio cross-chain da Base: non è "aggiungere un'altra distribuzione", ma "portare i componenti verso la distribuzione", convalidando la componibilità in una densità di sviluppatori più ampia.

Se stai davvero lavorando su "componenti standard", ti interesserai naturalmente della distribuzione: i componenti possono essere utilizzati solo in grandi quantità, altrimenti non si evolveranno più rapidamente, non diventeranno più stabili e alla fine non diventeranno l'opzione predefinita.

Se l'infrastruttura AI-first circola solo all'interno di una singola rete, l'area di utilizzo dei componenti è limitata, il feedback degli sviluppatori è limitato e l'ecosistema può facilmente diventare un giardino chiuso. Vanar inizia a essere utilizzabile cross-chain da Base, da questa prospettiva sembra più una scelta reale:

Mettere i componenti in luoghi più densi e con più applicazioni per gli sviluppatori, aumentando la frequenza di accesso e utilizzo, farà sì che la "componibilità" raggiunga veramente una scala.

Questo influenzerà direttamente il percorso di valore di $VANRY : quando più ecosistemi possono richiamare lo stesso set di componenti intelligenti e capacità di liquidazione, l'area di utilizzo si espande e il percorso di accumulo del valore potenziale è più chiaro.

5) Perché il pagamento/la liquidazione è un argomento obbligatorio per l'AI-first? Perché senza un ciclo chiuso, gli sviluppatori rimarranno sempre a un livello di "utile ma non generatore di valore".

Scoprirai che molte applicazioni AI "sembrano molto utili", ma a lungo termine non riescono a crescere: perché si fermano ai livelli di suggerimento e strumenti, mancando di un ciclo chiuso in grado di attivare attività economiche reali. Questo è ancora più vero per il Web3: se un agente intelligente prende una decisione, se non può entrare senza problemi nel tracciato di liquidazione, può solo fornire "indizi", rendendo difficile passare all'"azione".

I Talking Points di Vanar sottolineano che "gli agenti intelligenti non utilizzano l'UX del portafoglio"; questa frase è in realtà molto cruciale:

Gli agenti intelligenti hanno bisogno di canali di liquidazione orchestrabili, non di dover premere pulsanti come se fossero esseri umani. Solo quando i percorsi di liquidazione esistono stabilmente, gli sviluppatori saranno disposti a trasformare le applicazioni degli agenti intelligenti in forme orientate alle imprese o alle attività reali.

Riportando questo punto nella prospettiva della "componibilità": la capacità di liquidazione non è un modulo aggiuntivo, ma l'ultimo pezzo del puzzle che deve esistere nella libreria standard. Altrimenti, il sistema che costruisci avrà sempre un'uscita mancante per "completare il compito".

6) $VANRY: più simile all'accumulo di valore derivante dall'uso da parte degli sviluppatori e dalla chiamata dei componenti, piuttosto che spinta da emozioni a breve termine

Se concordi con il percorso "componenti standard + distribuzione", allora $VANRY è più facile da comprendere con la logica infrastrutturale:

non si tratta di scommettere su un interesse a breve termine, ma di scommettere sulla domanda di utilizzo a lungo termine che emerge quando questo strato di agenti intelligenti viene adottato da più applicazioni e richiamato da più ecosistemi.

Questa è anche l'ultima frase dei Talking Points: "prontezza, non narrazioni". In parole più semplici:

Quando il prodotto viene realmente utilizzato, il valore si accumula in modo molto semplice; ma quando il valore dipende dalla narrazione, la crescita è spesso più fragile.

Nell'era dell'AI, questa differenza diventerà più evidente. Poiché le aziende, le istituzioni e i team che si dedicano seriamente alle applicazioni saranno sempre più sensibili alla "deliverabilità". Chi può ridurre il costo di consegna delle applicazioni degli agenti intelligenti, è più probabile che diventi la prossima scelta infrastrutturale.

Conclusione: i vincitori nell'era dell'AI sono spesso quelli che semplificano le "capacità complesse".

Guardando il messaggio centrale di @Vanarchain , scoprirai che non ha fretta di presentarsi come "la catena AI che racconta le storie meglio". In realtà, somiglia più a ciò che consente agli sviluppatori di utilizzare senza problemi: ridurre capacità complesse come memoria, ragionamento, automazione e liquidazione in componenti componibili, e quindi espandere l'area di utilizzo attraverso la distribuzione cross-chain.

Questa strada non è necessariamente la più rumorosa, ma se gli agenti AI diventano davvero una forma d'uso importante nel Web3, il valore dell'infrastruttura deriverà maggiormente dall'essere "adottati in modo continuo". A lungo termine, semplificare le capacità complesse è spesso più significativo che "espandere ulteriormente i concetti".